L'intelligenza artificiale sta bussando sempre più insistentemente alle porte dell'industria del doppiaggio, sollevando interrogativi cruciali sul futuro dei professionisti del settore. Mentre alcune realtà tentano approcci collaborativi, altre sperimentazioni hanno scatenato reazioni decisamente negative, come dimostra il recente caso Amazon Prime Video.

Il caso Amazon Prime Video: quando l'IA non è gradita

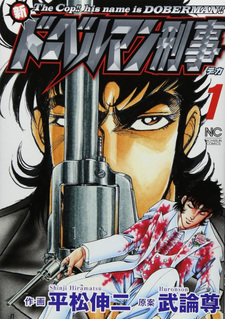

Proprio di recente, la piattaforma di streaming Amazon Prime Video si è trovata al centro di una controversia significativa. L'azienda aveva pubblicato un doppiaggio inglese di alcune serie anime, tra cui Banana Fish, realizzato interamente con intelligenza artificiale, scatenando immediatamente la rabbia dei fan e dei doppiatori professionisti. La reazione negativa è stata così forte che Amazon ha fatto marcia indietro, rimuovendo rapidamente il doppiaggio IA e eliminando l'esperimento.

Questo episodio ha messo in luce una verità fondamentale: il pubblico degli anime non è disposto ad accettare compromessi sulla qualità del doppiaggio, e i doppiatori vedono nell'IA una minaccia concreta alla loro professione e al loro sostentamento.

L'approccio collaborativo: il caso 81Produce ed ElevenLabs

In netto contrasto con l'esperimento fallito di Amazon Prime Video, l'agenzia giapponese 81Produce ha annunciato questa settimana una partnership con la società di software IA ElevenLabs che tenta un approccio radicalmente diverso. L'accordo, presentato lunedì 15 dicembre, si basa su tre pilastri fondamentali: consenso, protezione e compenso.

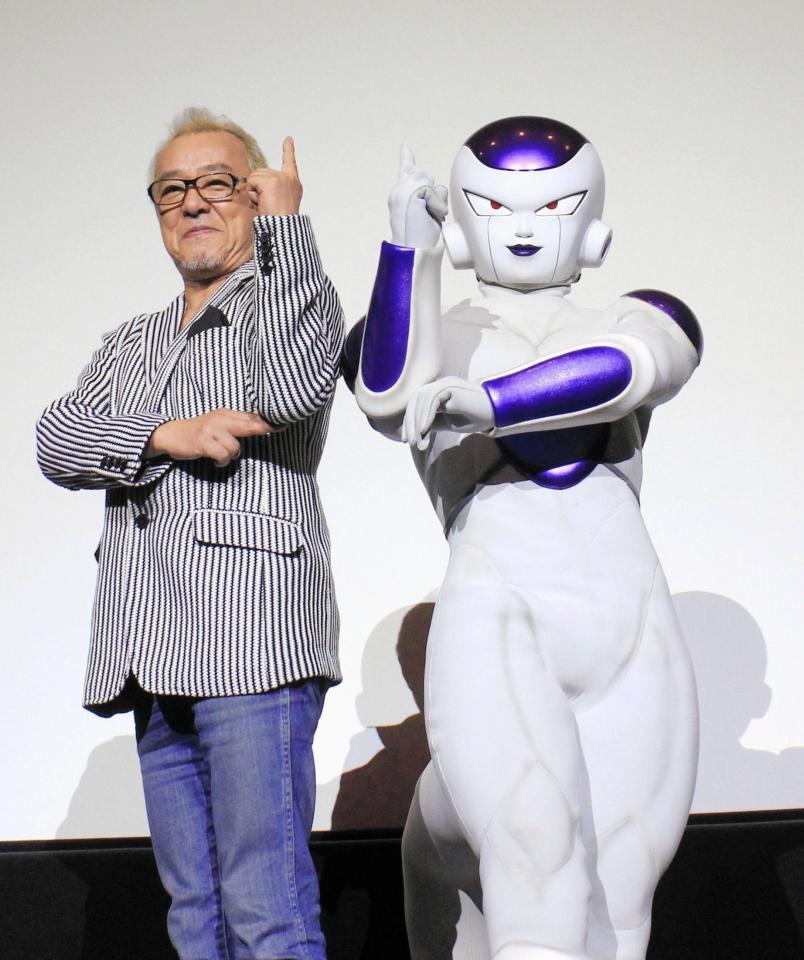

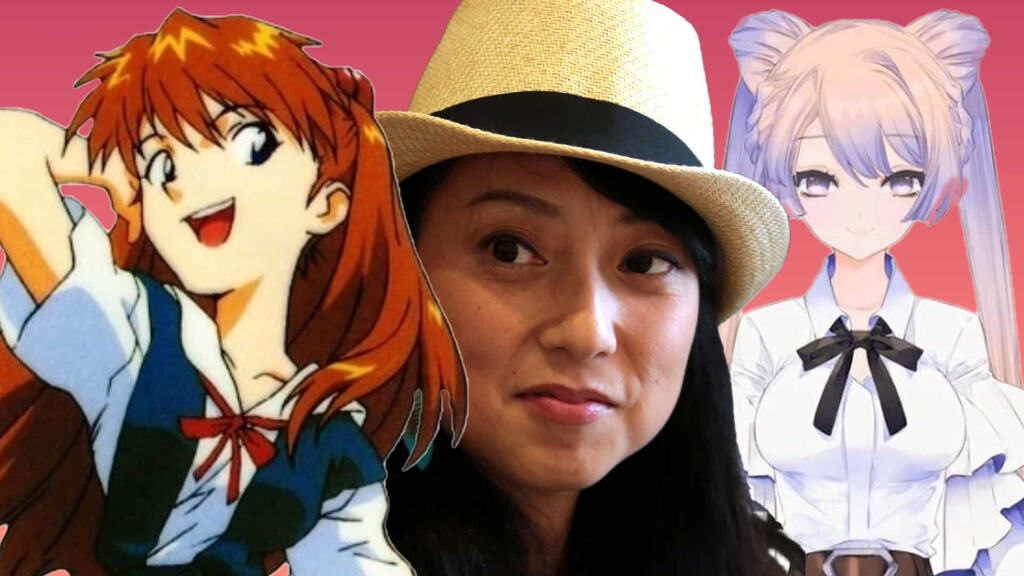

81Produce rappresenta oltre 400 doppiatori giapponesi, tra cui veri e propri nomi di punta del settore. Parliamo di Shinichirō Miki , Takumi Fujiwara di Initial D e Kojirō/James nei Pokemon, di Ryūsei Nakao, che ha prestato la sua voce al temibile Freezer in Dragon Ball Z , fino ad arrivare a Rie Takahashi, recente ospite di Crunchyroll a Lucca Comics & Games, celebre per aver interpretato Emilia in Re:Zero -Starting Life in Another World- e di Ai Hoshino in Oshi no Ko

L'agenzia ha stretto questa alleanza con un duplice obiettivo: da un lato proteggere le voci dei propri talenti dall'uso non autorizzato dell'intelligenza artificiale generativa, dall'altro permettere comunque la creazione di doppiaggi multilingue autorizzati, garantendo così nuove opportunità controllate e remunerate per i propri artisti.

Come funzionerebbe il sistema

Secondo quanto dichiarato da ElevenLabs, la loro tecnologia sarebbe in grado di prelevare campioni vocali con il consenso dei doppiatori e produrre doppiaggi IA in ben 29 lingue diverse. L'idea è quella di migliorare la produttività per i servizi di streaming globali, mantenendo però i diritti dell'attore originale e garantendogli nuovi flussi di entrate attraverso royalty.

Per contrastare gli abusi, la partnership prevede l'utilizzo di tecnologie di protezione come VoiceCAPCHA, watermark digitali e conformità agli standard C2PA (Coalition for Content Provenance and Authenticity), strumenti pensati per rilevare e bloccare l'uso non autorizzato delle voci degli artisti rappresentati da 81Produce.

Le preoccupazioni dei doppiatori sono legittime

Nonostante questi tentativi di regolamentazione, le preoccupazioni della categoria rimangono più che giustificate. Nell'ottobre 2024, numerosi doppiatori giapponesi hanno formato un gruppo chiamato "No More Mudan Seisei AI" (Ma più IA Generativa Non Autorizzata), proprio per opporsi all'uso indiscriminato dell'intelligenza artificiale. Tra i membri di spicco figura proprio Ryūsei Nakao di 81Produce, a dimostrazione che anche all'interno di agenzie che sperimentano con l'IA esiste una forte sensibilità sul tema.

I rischi sono concreti: perdita di opportunità lavorative, svalutazione della professione, uso improprio delle proprie caratteristiche vocali e, in definitiva, la possibilità di essere sostituiti dalla propria stessa voce sintetizzata.

Altri esperimenti nel settore

Il panorama giapponese sta vedendo diverse sperimentazioni. L'agenzia Aoni Production ha stretto nell'ottobre 2024 una partnership con la piattaforma vocale IA CoeFont, utilizzando i dati vocali di 10 doppiatori, tra cui la leggendaria Masako Nozawa (voce di Goku), per creare voci replicate da usare per assistenti virtuali, dispositivi medici e robot. Significativamente, questo progetto esclude esplicitamente l'uso per animazione e doppiaggi, riconoscendo la sensibilità del tema.

Anche il popolare doppiatore Yūki Kaji ha lanciato nel 2024 il progetto Soyogi Fractal tramite crowdfunding, raccogliendo oltre tre volte l'obiettivo iniziale. L'iniziativa mira a offrire ai creatori modi controllati per usare la sua voce, prevenendo al contempo abusi illegali.

Il bivio del doppiaggio

L'industria del doppiaggio si trova davanti a un bivio cruciale. Da un lato, l'IA potrebbe effettivamente facilitare la localizzazione di contenuti in più lingue, rendendo accessibili opere che altrimenti non riceverebbero mai un doppiaggio per motivi economici. Dall'altro, esiste il rischio concreto che le aziende usino questa tecnologia principalmente per tagliare costi e marginalizzare i professionisti.

Il caso Amazon Prime Video dimostra che approcci unilaterali e privi di trasparenza vengono respinti con forza. Si spera quindi che eventuali utilizzi dell'IA nel doppiaggio passeranno attraverso il consenso degli artisti, compensi equi, tutele legali robuste e, soprattutto, il mantenimento di standard qualitativi elevati.

La tecnologia avanza rapidamente, ma spetta all'industria, ai sindacati e ai governi garantire che questo progresso non avvenga a spese di chi ha fatto del proprio talento vocale una professione. Il futuro del doppiaggio dipenderà dalla capacità di bilanciare innovazione e tutela dei diritti umani e artistici.

Fonte: Anime News Network

Non è mica una novità. Il crowdfunding per sistemi di sintesi vocale (non è un doppiaggio con sistemi generativi) è sempre stato fatto, da almeno una decina di anni. Doppiatori che hanno già fatto questa cosa sono, per esempio:

1) Kikuko Inoue (Haruno Sora - Voicepeak);

2) Mai Kadowaki (Tsuina-chan - Voiceroid2);

3) Yoshino "Bocchi" Aoyama (Koharu Rikka, Cevio AI, Voisona, Voicepeak).

A questo si aggiungono anche doppiatori emergenti (sì, proprio gente agli inizi) che hanno partecipato a questo genere di progetti.

Esiste anche un personaggio con una voce totalmente artificiale, creata con fonemi predisposti con il software Audacity e con un distinto tono robotico (Adachi Rei).

Esistono anche versioni in Inglese (proprio il personaggio basato su Kaiji ha anche una versione inglese sulla piattaforma Voisona Song e Voisona Talk).

La quasi totalità dei programmi consente un uso commerciale con licenza apposita.

Giusto per dare un'idea più precisa, Coefont è una compagnia che offre tre tipi di servizi:

1) Sintesi vocale per usi amatoriali o commerciali, fatta con la voce di utenti ovvero con professionisti (la compagnia ha 4 personaggi che usa per promuoverla - Millial, Allial, Avenir, Canel, quest'ultimo doppiato da Toshiyuki Morikawa, per fare un nome più famoso). La compagnia parla di AI per la generazione delle voci ma se devo essere onesto la qualità rispetto ai software "scatolati" è abbastanza bassa per certe cose. Faccio presente che l'uso delle voci, nel caso non sia gratuito, garantisce un compenso all'utente che ha generato la voce;

2) Sintesi vocale "al volo" per streaming ecc.

3) Servizio di registrazione voci e/o messaggi per eventi o per ricordi in caso, tra l'altro, la persona non sia più tra i vivi.

Si sono anche espansi fuori dal giappone con Coefont global (cosa che ANN si è ben guardata da segnalare) ma non ho idea se abbiano avuto successo o meno.

Buona fortuna a pensare che questo possa fermare alcunchè. Mi ricorda la RIAA e la pirateria nei primi anni 2000.

Lasciamo i governi fuori da tutto. Regolare non è mai la soluzione. Sarà il mercato a decidere, e checché se ne dica, il flop di Amazon dimostra che in realtà le previsioni dei catastrofisti sono tutto fuorché scontate.

Direi che i sindacati e le associazioni di categoria insieme a strutture politiche create ad hoc fatte da persone competenti (come in UK ad esempio, non mettendo i soliti politicanti vecchi e ignoranti) hanno tutto il diritto di vigilare

Chi ancora pensa alle multinazionali che fanno tutto e i governi imbelli non ha capito molto di quello che un governo può fare. Si veda il caso Meta negli Stati Uniti.

Ribadisco: ci è voluto un governo per la figura di palta di Amazon con Banana Fish? No.

E poi, ancora, i servizi di sintesi esistono da millenni. Adesso improvvisamente non vanno più bene? Qual è il prossimo passo, chiedere l'abolizione per legge di Vocaloid?

Purtroppo l'esperimento se così vogliamo chiamarlo sta andando avanti non si è mica fermato è era inizia già da molto tempo, non su gli anime.

Ci sono già ora prodotti doppiati solo content IA di cui nessuno parla prob perché non "fanno rumore" al livello mediatico.

Probabilmente Amazon non accetterà mai ciò che propongono i Giapponesi.

Ovvero, l'artista deve rimanere in controllo del proprio talento, può pagare un servizio per produrre contenuti dai propri dati digitalizzati di cui mantiene il controllo e solo lui ne può disporre. L'idea sarebbe che ad esempio un doppiatore possa prendere in carico più lavori, pagando questo servizio di ai generativa per produrre in sua vece quello che normalmente gli richiederebbe presenza e tempo e vendendo il risultato alle aziende che chiedono la sua prestazione. Eventualmente questo può portare ad un cambiamento degli stessi ma non creerebbe una concorrenza con l'artista stesso.

Da capire se però può generare concorrenza con altri artisti per i medesimi lavori.

Altra cosa interessante, l'ia potrebbe permettere ad un doppiatore di preservare la propria voce per doppiare personaggi più giovani oppure per doppiarsi in lingue diverse.

Tutto questo, ribadisco, in mano all'artista: l'ia è il servizio che gli produrrebbe i contenuti di cui però ha pieno controllo e nessun altro dovrebbe poter riprodurre le sue prestazioni senza consenso e compenso.

Una delle sue cose migliori (come di altre agenzie ugualmente strutturate) è la capacità di scovare i talenti e di crescerli "in casa" - dal 2010 circa bandisce un concorso annuale per aspiranti seiyuu, con qualche migliaio di partecipanti, scremati fino a una ristretta selezione finale. Il primo anno per dirne uno, vinse Takuya Eguchi (Hachiman, Loid, e tantissimi altri). Una volta scoutati li inseriscono nella propria scuola, e (se) una volta pronti, li fanno esordire.

Ora, la questione della protezione dei propri artisti è sacrosanta, e l'intenzione di evitare utilizzi indiscriminati è primaria.

Ma, allo stesso tempo, poter disporre dell'utilizzo delle voci campionate (con il consenso e la diretta remunerazione dei "proprietari"), anche mettiamo caso solo per le localizzazioni all'estero, li metterebbe in una situazione di vantaggio, forti del "pacchetto" di artisti top tier sotto contratto.

Il peggior scenario per l'intero settore che immagino, è quello di una diminuzione di nuove promesse, chiusi da un sistema che premia l'ottimizzazione dei costi, che sì protegge gli artisti, ma quelli che già sono dentro, affermati e richiesti per le localizzazioni (un po' come il nostro settore cinematografico e seriale..." una volta c'erano i ruoli adesso li fa tutti Favino" cit.).

Per quanto ami moltissime delle voci attuali, sempre più spesso riconosco il loro essere sovrautilizzate, per ruoli che sarebbero potuti andare ad esordienti.

Tutti quelli al momento sulla cresta dell'onda lo sono stati ed hanno dovuto affrontare anche dure gavette. Se il mercato premiasse una situazione di blocco in nome dell'ottimizzazione dei costi, e del grosso nome spendibile sul mercato internazionale ("la voce di [inserire seiyuu super inflazionato] finalmente in thailandese sul nuovissimo isekai"), per me sarebbe più un incubo che "il sogno di sentire [...]in italiano". Con tanti saluti al settore lavorativo interno, sempre che non si inventi qualcosa, dal chiedere i sussidi, al combattere il fuoco col fuoco... Ecco il nuovo isekai col protagonista super OP con la voce campionata di Favino (brrrr....)

Comunque restando sull’articolo, l’idea è buona ma c’è da vedere come sarà applicata. Serve un compenso decente per i doppiatori E una qualità accettabile del prodotto finale, non è così semplice da realizzare.

Oppure ci sono quelli amatoriali da anni che però si fa finta che non esistano sennò la narrazione crolla miseramente, esempio a caso (in Giapponese) preso da Youtube: https://www.youtube.com/watch?v=nAUMOVAv7rw

Ma le cose sono un po' più sfumate. So di diversi doppiatori emergenti che stanno usando questo genere di programmi ,e manco sono affiliati a grandi agenzie. Ho avuto a che fare personalmente con una doppiatrice, che ha debuttato con un programma di sintesi "AI" (AI Voice e a breve anche AI Voice 2) dopo aver fatto per un paio d'anni un personaggio in un voice drama, con audizione tramite internet per una non-profit.

Tra l'altro ci sono anche per materiale R18 (Lusty Kiss production e il software Coeiroink, pubblicano sulla sezione R18 di DLsite, Dlisite Maniax).

Ben vengano le sfumature. Il mio augurio è che tra gli emergenti di ogni generazione il talento possa sempre uscire fuori, affiliati o freelance. Programmi e strumenti non sono mai nemici sono d'accordissimo. È sempre l'uso che ne si fa (o l'abuso, da parte di chi pensa solo ai guadagni/costi)

Penso che tutti qui siano a conoscenza della loro esistenza, e del fatto che sono una cosa completamente diversa da Amazon che pubblica sulla sua piattaforma a pagamento un doppiaggio AI con una qualità peggiore di quella di quel video.

E' fatto con uno dei software che ANN (e che lì'articolo che ha pedissequamente copiato, sbagliando) ha accostato alla notizia originale parlando di Kaiji, e di "AI".

E quindi qualcuno mi deve spiegare perchè improvvisamente anche questo non dovrebbe andar bene.

La "narrazione" di "sostituzione silente" con i contenuti è una fesseria proprio perché sono anni che questi sistemi esistono e adesso usano anche dei modelli (non recenti) di linguaggio. Pero' i doppiatori sono compensati, come ho detto ci sono anche emergenti che li usano come punto di partenza, ecc.

Quindi non è un "viene giù tutto".

E il mercato infatti l'ha rigettato perché faceva schifo. Invece di farlo notare si sta invece ancora a fare discorsi basati su teorie di fine '800.

scusate ma quando trump ha dato inizio al suo mandato chi c'era in prima fila?

con le scemo arancione che spara cazzate a raffica chi vuoi che si occupi di quello che stanno facendo le grandi aziende dietro le quinte.

tra un paio di anni vedere attori morti recitare in un film sarà uso comune perchè daranno qualche milione alle famiglie e firmeranno le liberatorie e la stessa cosa varrà per le voci .

oggi siamo nel far west per quanto riguarda le leggi sull'uso delle intelligenze artificiali e più a lungo resterà cosi più ne approfitteranno

"Secondo quanto dichiarato da ElevenLabs, la loro tecnologia sarebbe in grado di prelevare campioni vocali con il consenso dei doppiatori e produrre doppiaggi IA in ben 29 lingue diverse."

quindi vorrebbe dire che il sistema campionando la voce del doppiatore giapponese sarebbe in grado di fornire un doppiaggio in un'altra lingua mantenendo quindi la stessa sonorità della voce originale ?

L'idea è quella. E sarebbe molto interessante vederne il risultato.

Però è fondamentale che rimanga un servizio al doppiatore che gli consenta di vendere il proprio lavoro e non qualcosa che altri possano sfruttare senza il suo consenso.

In effetti sarebbe curioso sentire come "suona" una voce giapponese che parla ad esempio in italiano senza le inflessioni dovute all'accento e paragonarla quindi alla versione originale.

Non è che hanno fatto dietrofront per “aumentare la qualità” dei doppiaggi, stanno semplicemente aspettando il momento in cui la gente si farà andar bene la stessa schifezza che adesso hanno tolto.

È un dubbio lecito. Non so come potrebbe andare.

Da un lato vorrei vedere l'alternativa alla scelta delle voci che spesso vediamo.

O doppiaggi che altrimenti non avremmo.

Dall'altra effettivamente vedresti sparire il doppiaggio.

Suppongo che in alcuni casi sia meglio e in altri peggio.

In quel caso i doppiatori dovrebbero sperare che le rispettive nazioni inizino a produrre abbastanza prodotti d’animazione per mantenere l’industria (o che si muova qualcosa per l’implementazione di un UBI, ma lo vedo molto lontano nel panorama attuale)

Ho un'idea: mettiamo l'AI a decidere turni lavorativi e paghe (anche per gli animatori) e le persone a doppiare. Può essere che esca qualcosa di più umano.

...Rispetto a questo liberismo squallido, che mette solo i profitti al centro e considera ogni rivendicazione umana un ostacolo da rimuovere.

Ma, che ora tocchi a burocrati e artisti subire l'evoluzione della tecnica, non tanto alla classe bassa, dopo decenni di produzioni escapiste, remake, apologie criminali e reazionarie, individualiste e disinteressate alle fratture sociali, forse è solo giusto così: che 3 programmi sostituiscano 30.000 persone che andranno a badare agli anziani o a fare le previsioni del meteo.

Però l'AI ci darà i doppiaggi in serbocroato e swaili, evvai!

Si prevedono forti rovesci sul versante settentrionale.

Secondo me la chiave è sempre a chi lasci il controllo: se è alle aziende o peggio ai sistemi di IA, no, se invece si tratta di dare strumenti ai doppiatori per vender il proprio lavoro e l'IA rimane un servizio a loro offerto, allora potrebbe anche essere bilanciato.

Devi eseguire l'accesso per lasciare un commento.